Essence of Linear Algebra

中英对照表

| English | 中文 |

|---|---|

| cross production | 叉积 |

| determinantion | 行列式 |

| eigenvalue | 特征值 |

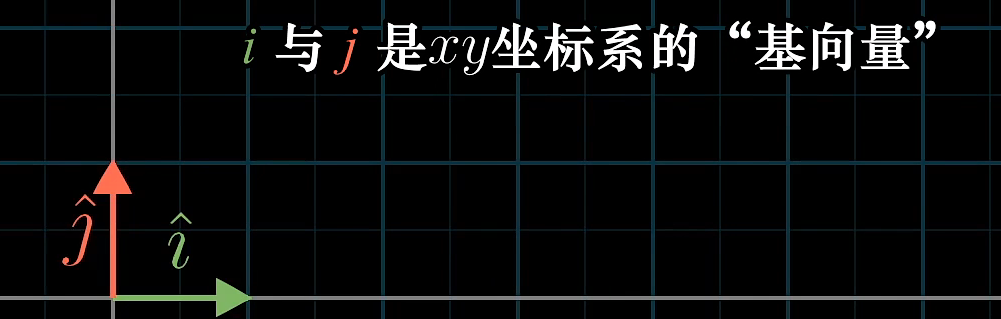

Vector

The introduction of numbers as coordinates is an act of violence.

AND on the flip side, it gives people a language to descrbie space and the manipulation of space using numbers that can be crunched and run through a computer.暴论:线代让程序员可以操纵空间。

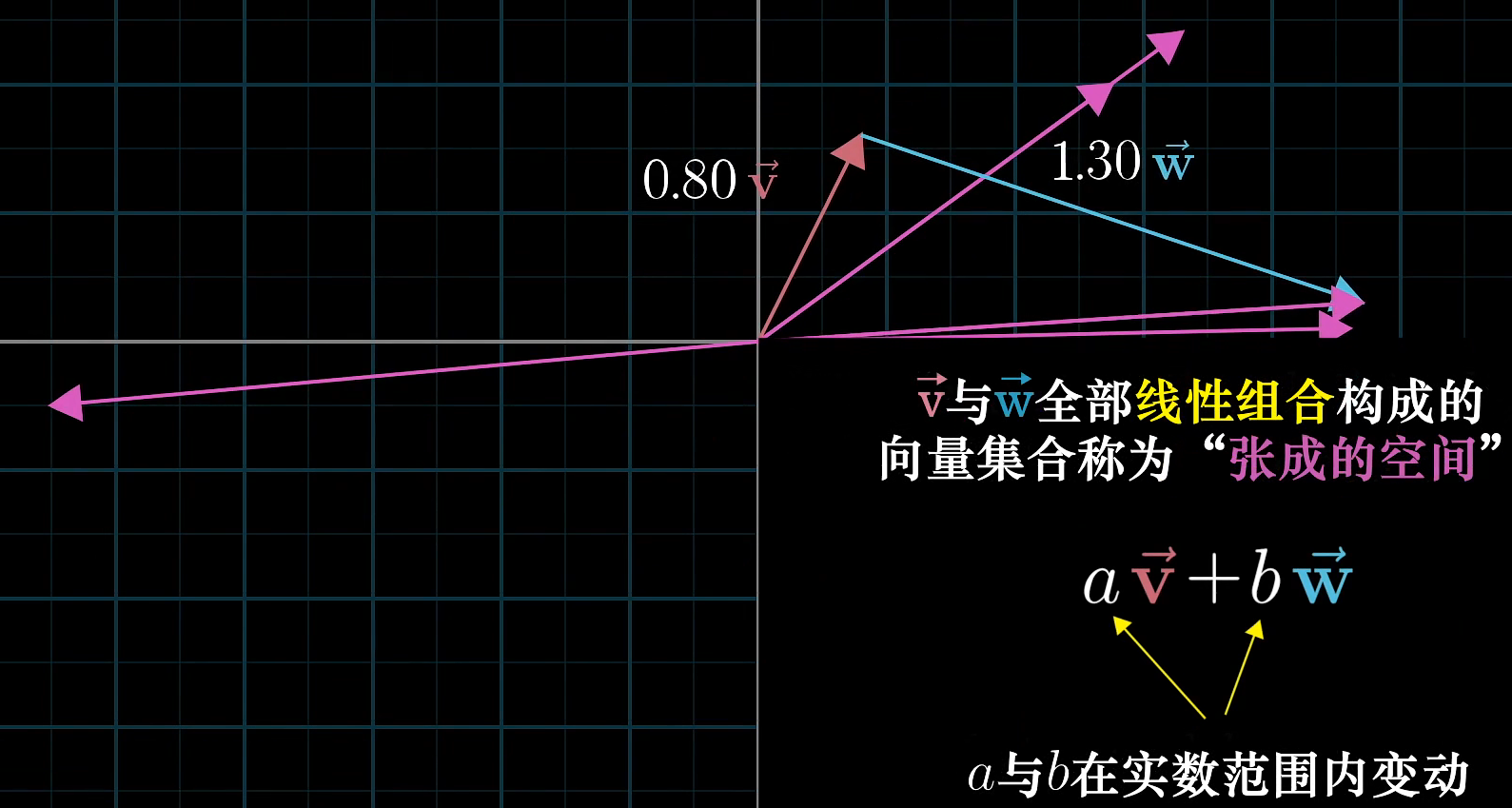

共线的向量,线性相关(Linearly dependent),张成的空间就是一条线(或原点);

不共线的向量,线性无关(Linearly independent),张成空间就是所有向量的集合;

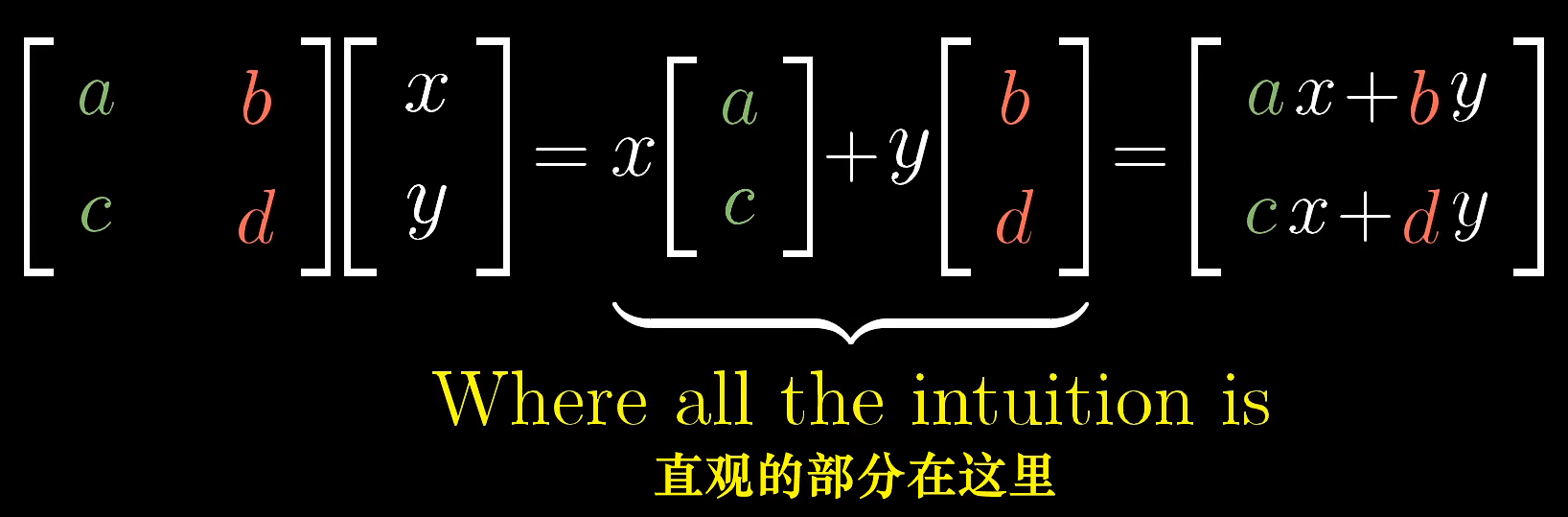

Matrix

kind of Linear transformation

好在线性代数只涉及线性变换;

矩阵可以理解为一种变换;

ac表示一个基变换后的位置,bd也是,因此1001等价于没变换;

知道基是怎样变换的,就知道了所有向量是怎么变换的;

正交变换是基向量保持长度且相互正交的变换(刚体运动);

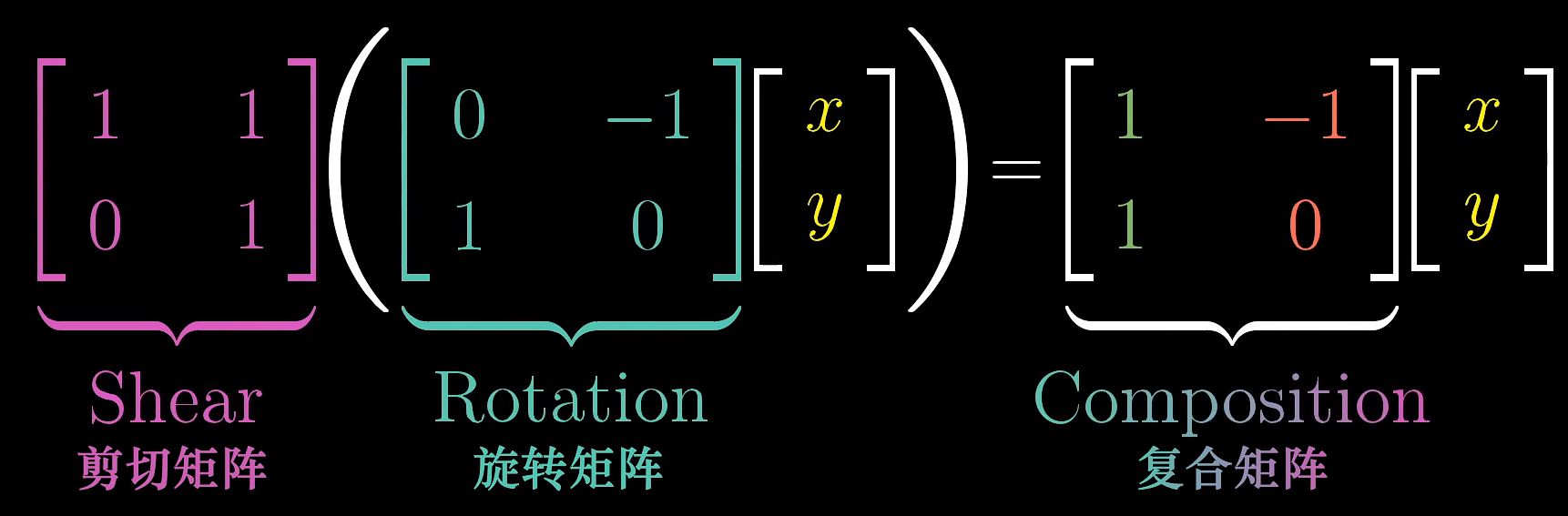

Matrix Multiply

单个矩阵是线性变换,那矩阵相乘就是复合变换。矩阵相乘的集合意义就在于使两个线性变换相继作用(apply one transformation then another)

非方阵代表跨纬度的变换;

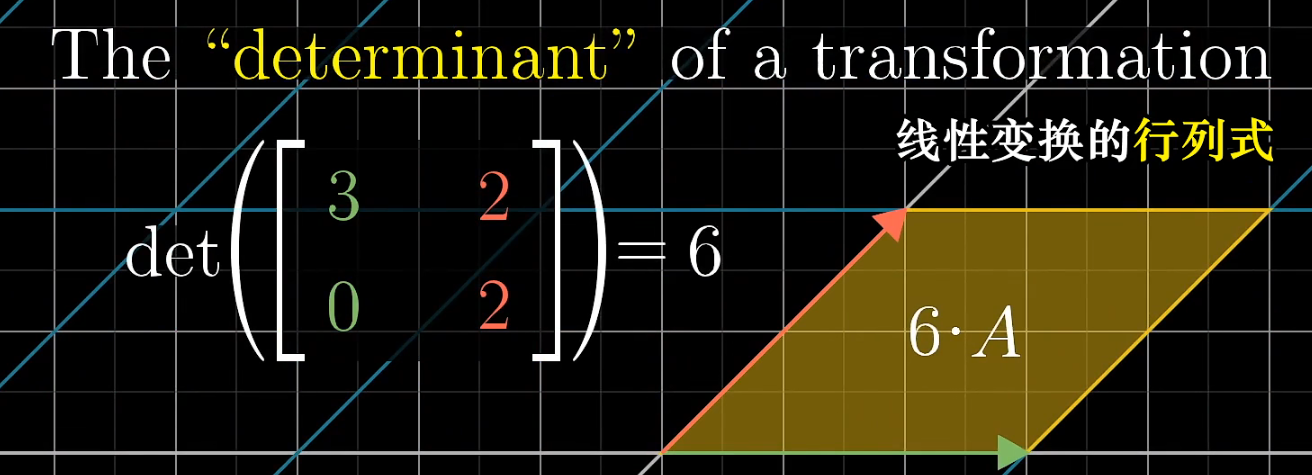

Determinant

这就是行列式determinant!👆

1x1的小格子,经过矩阵变换后的面积等于对应行列式的值。

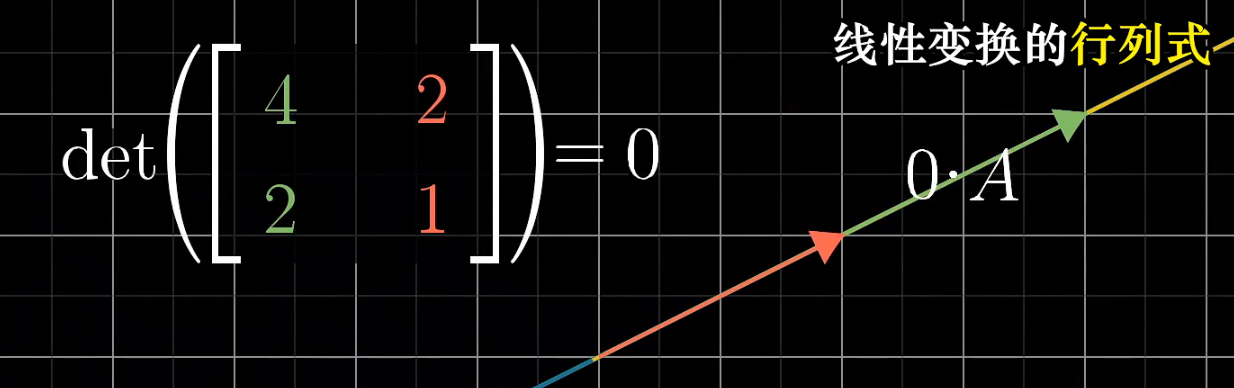

如果行列式为0,全都压扁了,是一个不可逆的变换,矩阵也是不可逆的。

行列式的值可以是负的,你的面积也能是负的吗?面积等于绝对值,负数代表空间orientation发生了改变(一张纸翻转了);

不过面积不能说明一切,高维是其它东西;

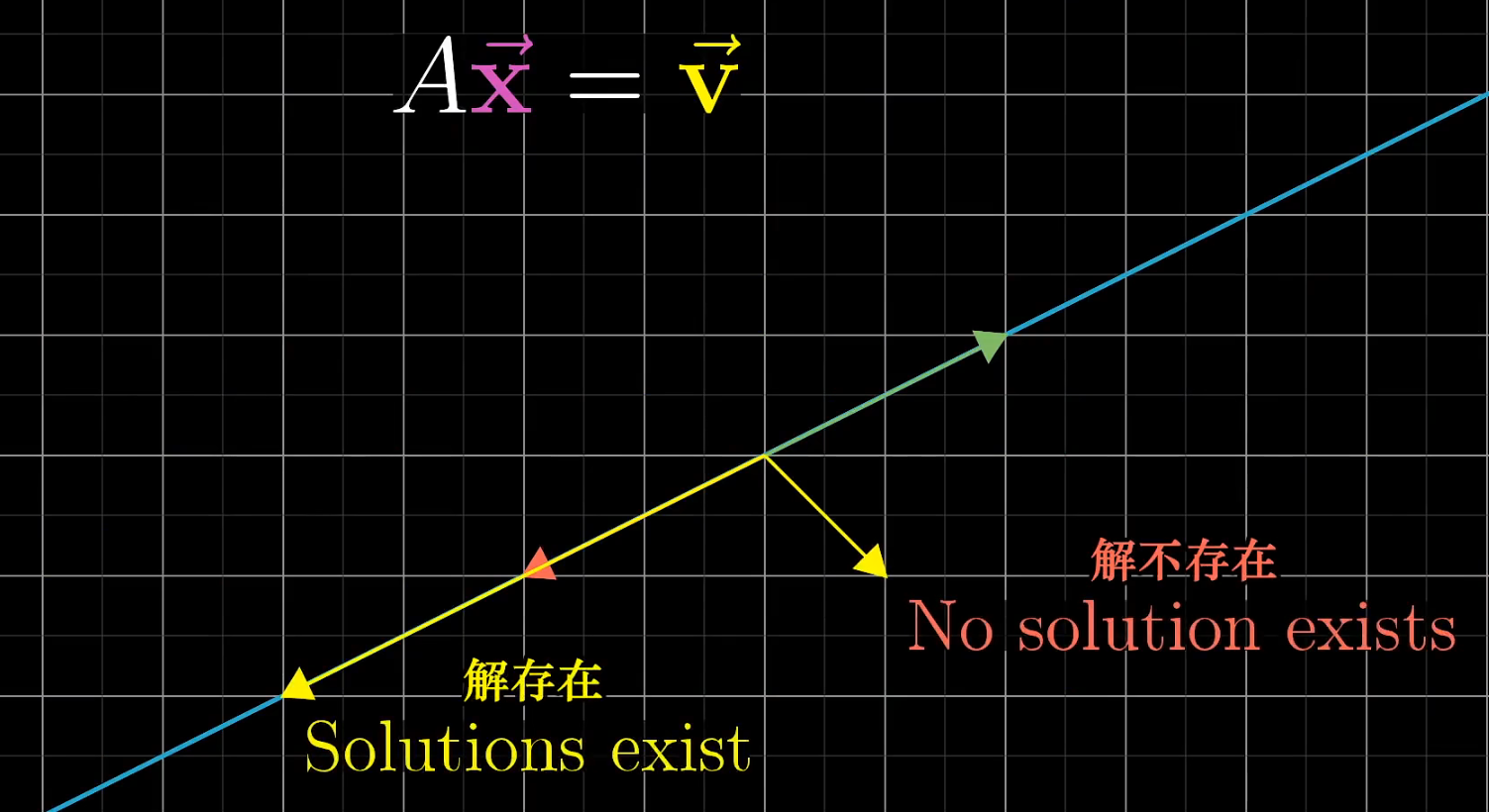

Inverse matrices & Column space & Rank

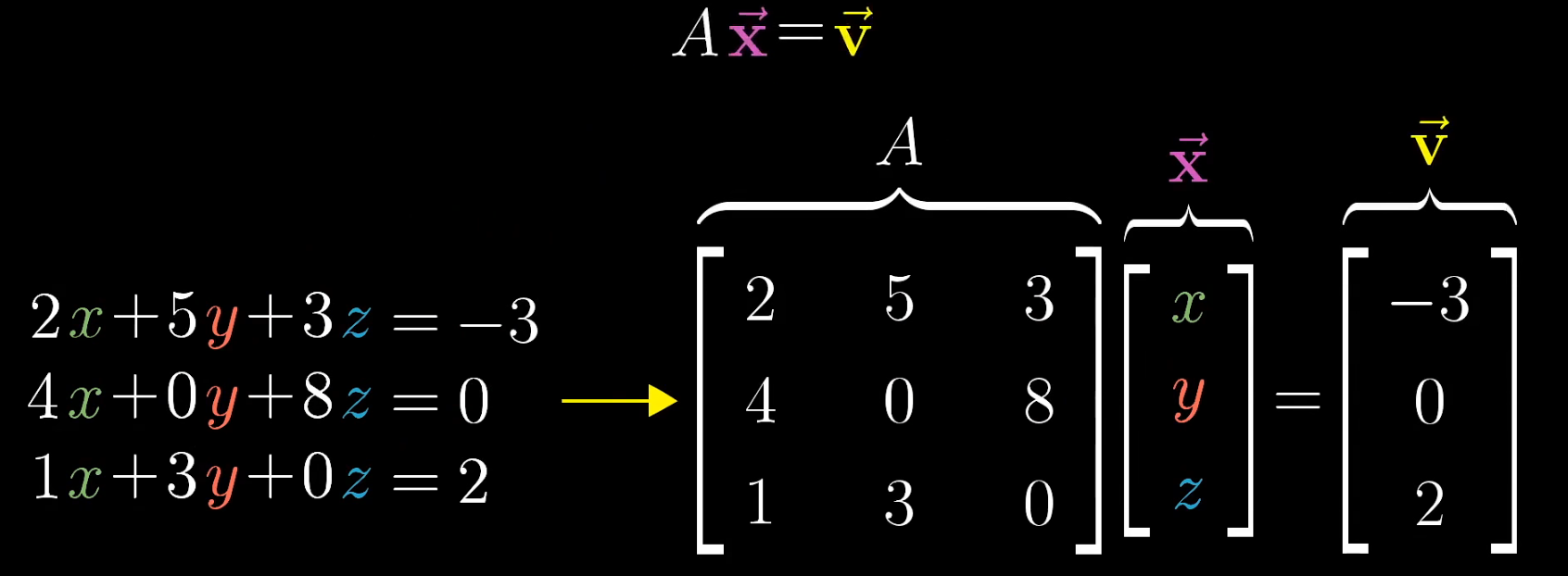

矩阵不只是操纵空间,还可以用来解方程组。

把方程组(equation system)转换成矩阵相乘,自然又回到操作空间的传统艺能来了;

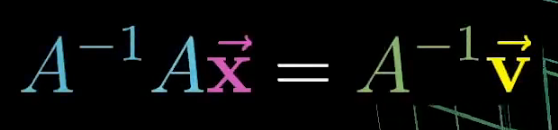

当行列式不为0时,求逆矩阵即可解方程组;

当行列式为0时,方程组仍然可能有解,前提是

关于秩的解释,视频 8分钟左右真的太精妙了。

秩代表变换后(列)空间的维度;(在方程组中,矩阵的秩刚好就是约束条件的个数)

所有可能的

变换后落在原点的向量集合,就是零空间null space 或者叫做 核kernel;

SVM中的核方法?

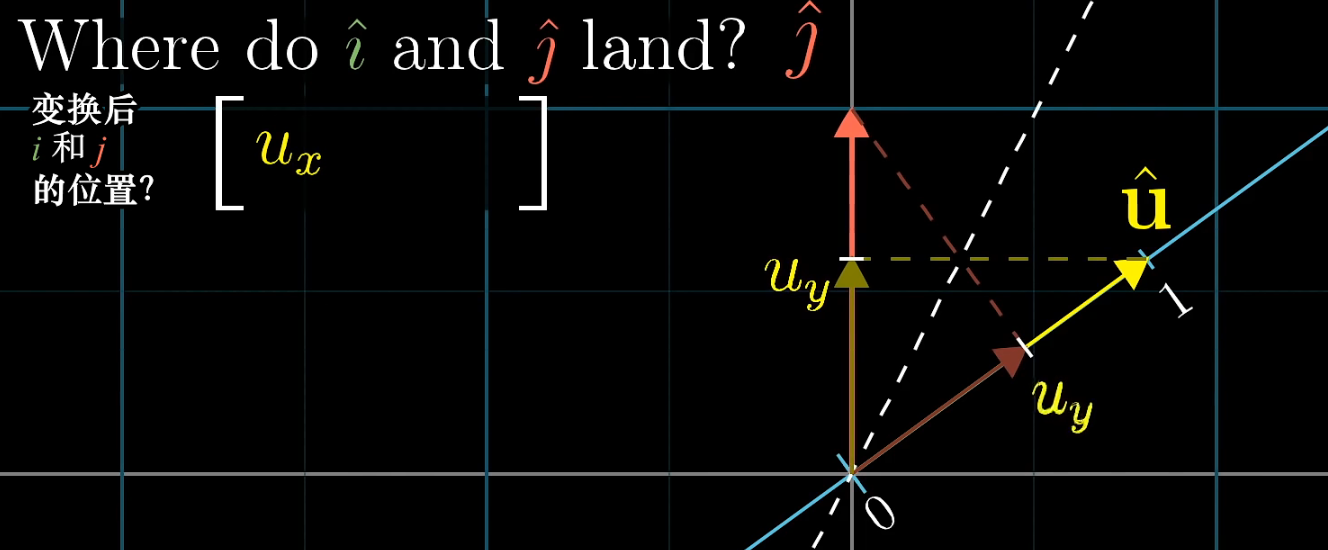

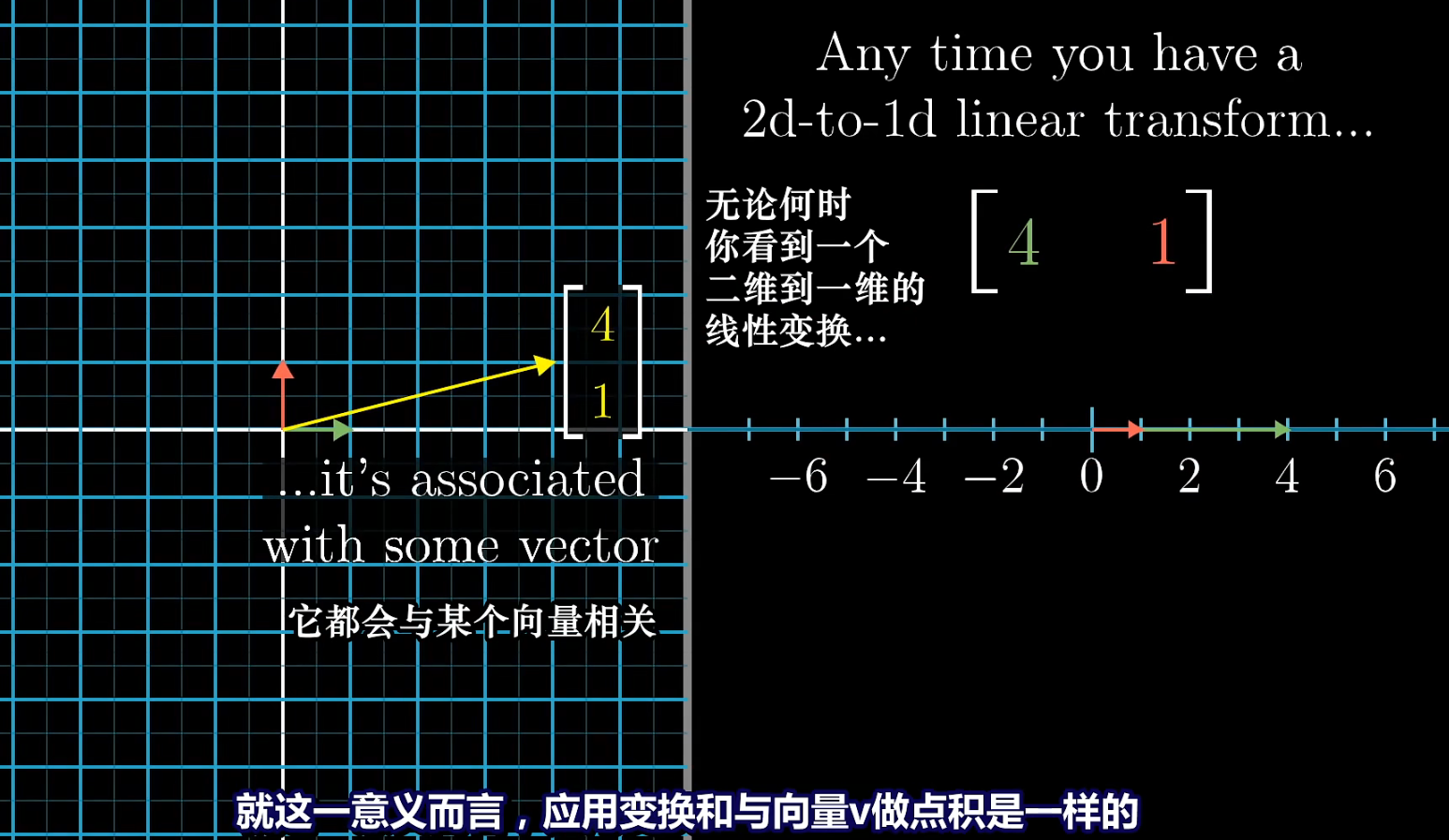

Duality of Dot Product

传统理解向量点积的方式为投影,但为了理解对偶性,先忘掉。

对偶性指的是自然而又出乎意料的对应关系。

Vector is the physical embodiment of a linear transformation.(向量是线性变换的载体)

对偶性的理解对理解希尔伯特空间、PCA IDA至关重要。

向量和对应的1×n矩阵之间有奇妙的关系,1×n矩阵代表的变换等价于与n×1的向量做点积;每一个向量都是某个矩阵的化身;每一个矩阵都与某个向量对应着;

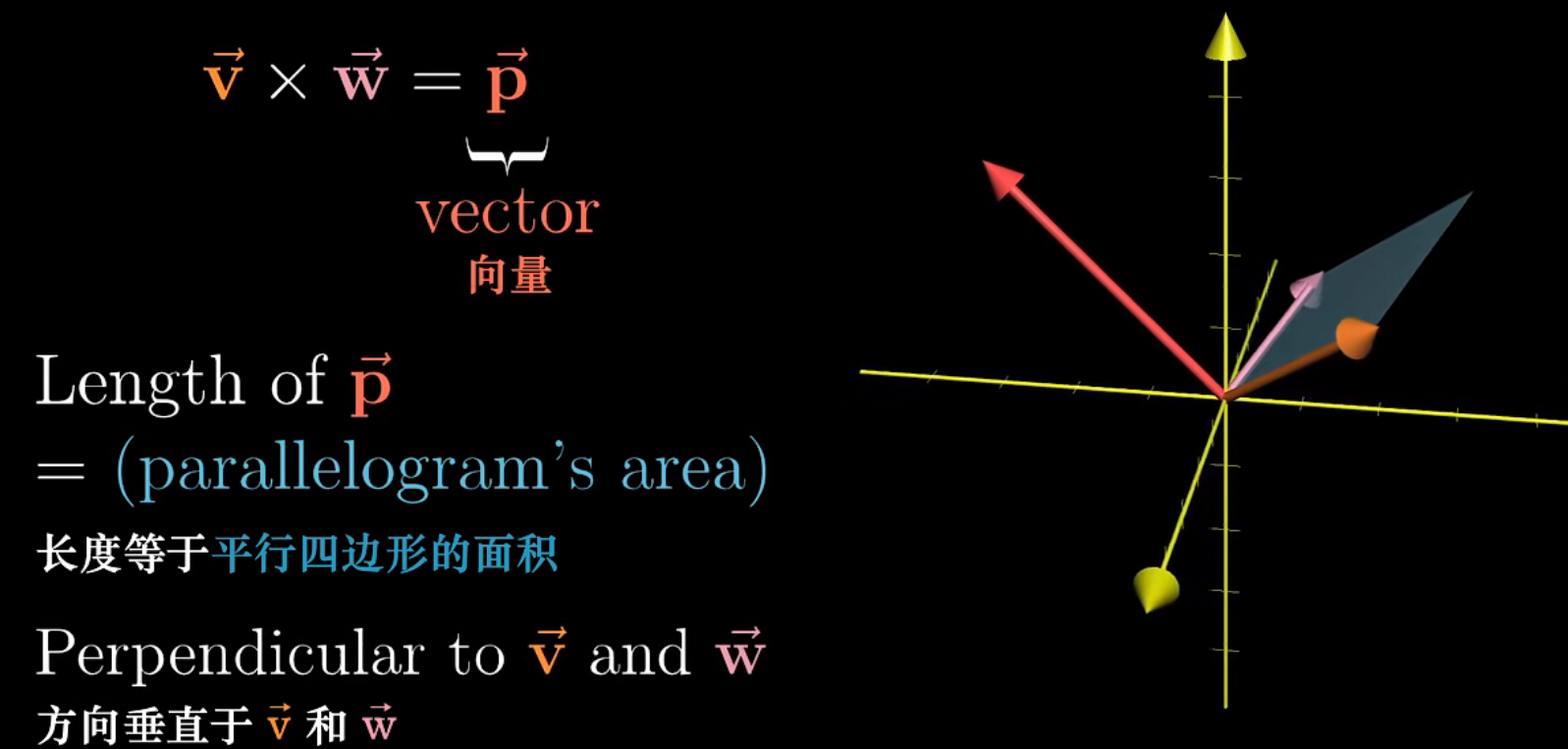

Cross Product

传统的解释如上图

Change of Basis

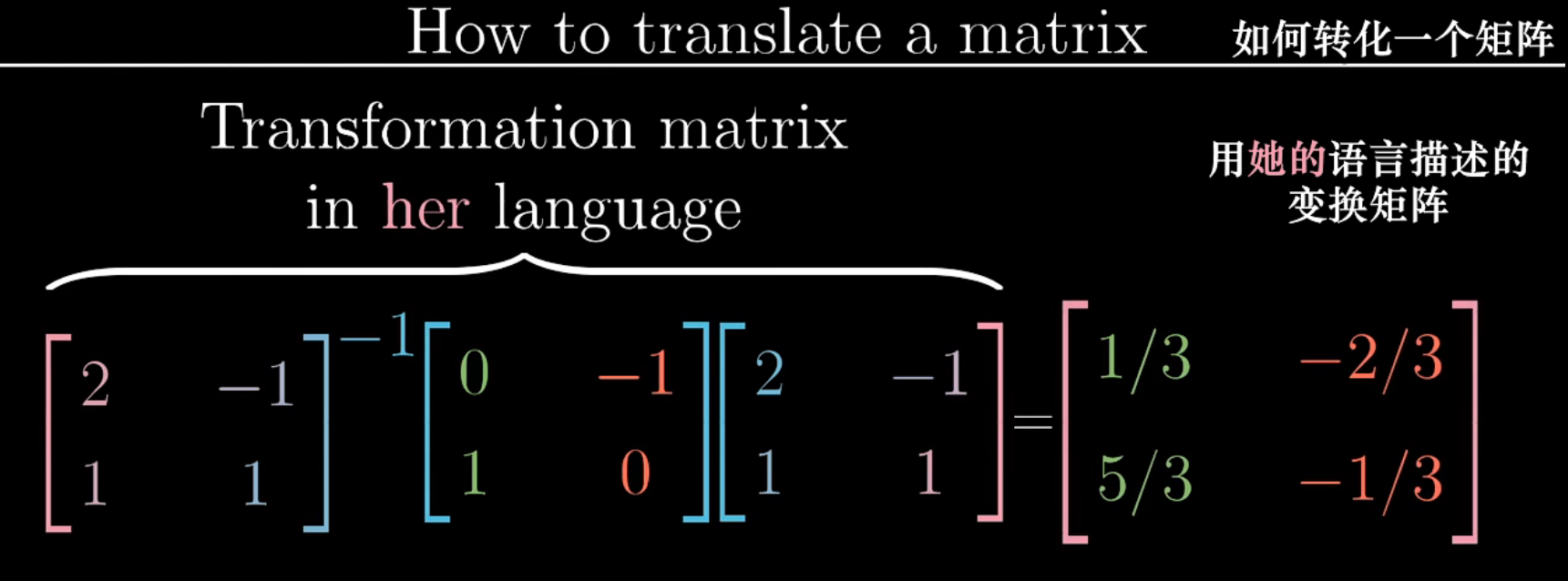

两个处于不同坐标系的人,该怎样交流?把他人的基向量放到自己的坐标系,得到变换矩阵即可。

对于另一个坐标系中的向量

表达式

Eigenvectors & Eigenvalues

作用:特征值为1的特征向量就是旋转轴

计算:

旋转变换特征向量在复向量空间中,剪切变换仅一个特征向量;

也有特征值唯一,特征向量不共线的情况(如将所有向量拉伸两倍)

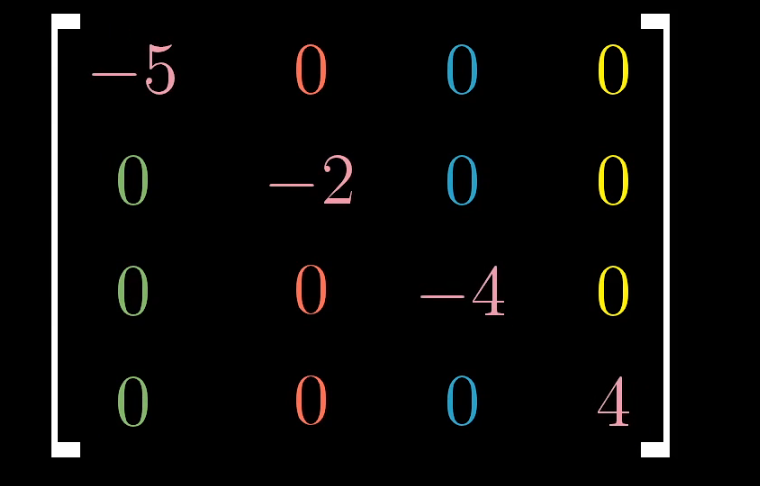

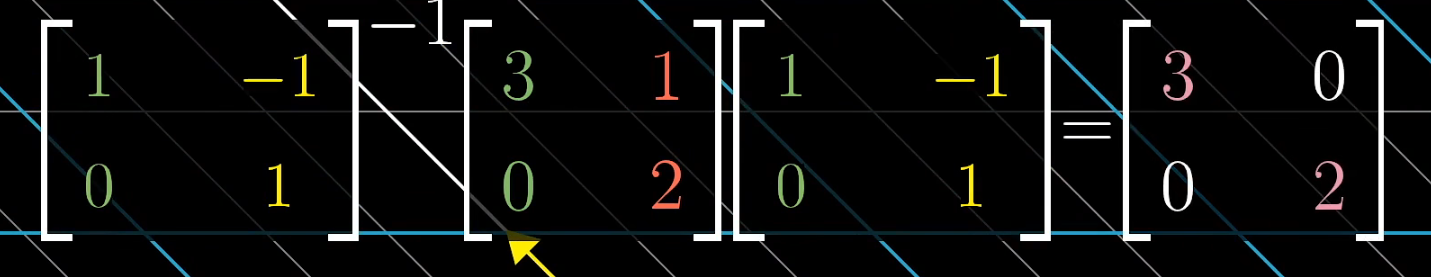

对角矩阵,所有的基向量都是特征向量,对角线上的值就是对应的特征值

如果有一天,想把两个不共线的特征向量[1 0] [0 1]作为新的坐标系的基,这个基变换的过程就是相似对角化;得到的矩阵必然是对角矩阵,且值为特征值。这样的特征向量也叫做特征基(eigenbasis);

为什么要大费周章去进行特征基变换呢,比如说上面这个

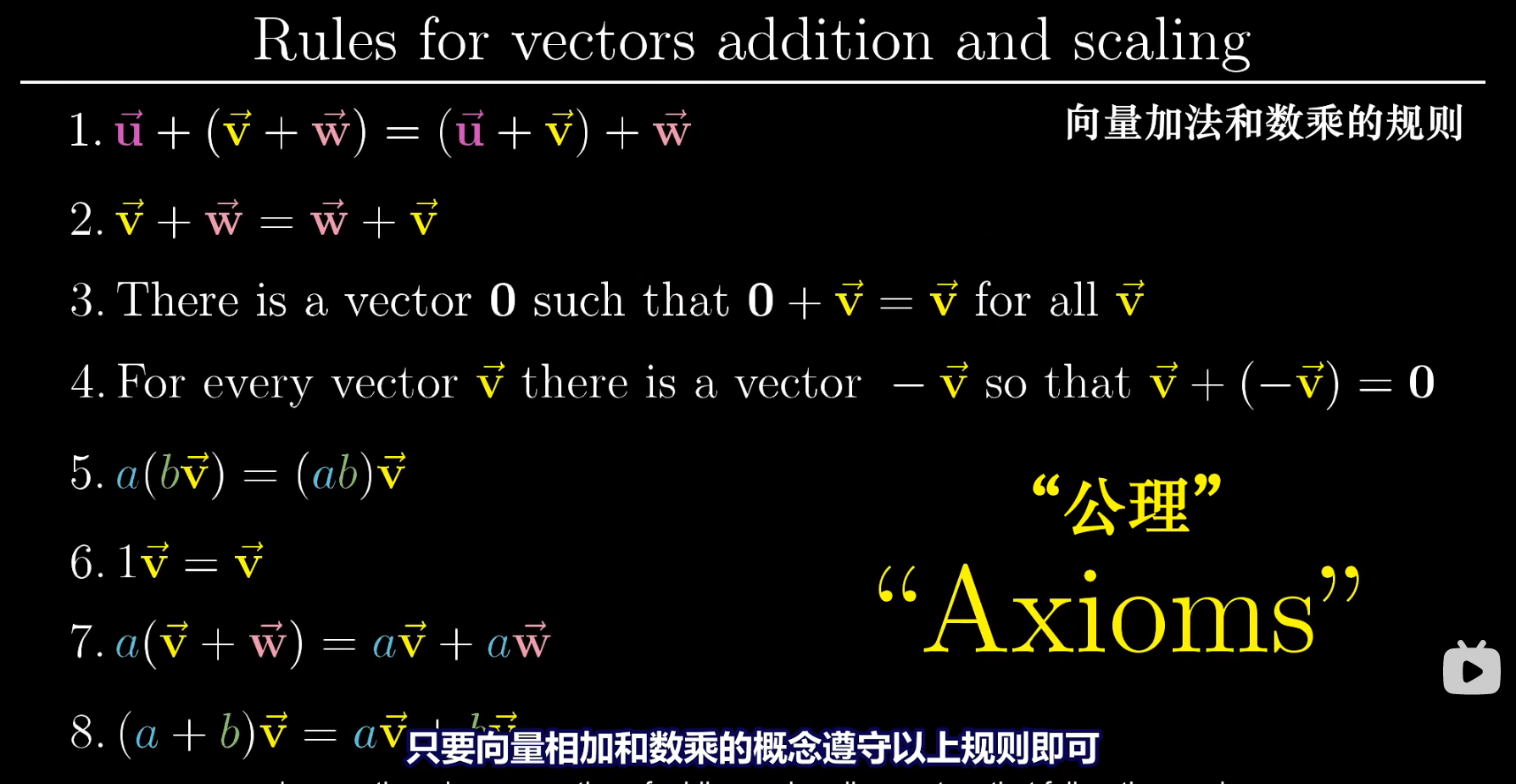

Vector Spaces

行列式、特征向量等与所选的坐标系无关…

函数求导也可以用矩阵完成…

所以向量究竟是什么?

向量不是个东西。

公理不是什么自然法则,是数学家定义的规则,联系了数学家与使用数学工具的人;向量可以是任何东西,点、箭头、函数、奇怪的生物…,只要他们满足这些公理定义的规则。

问向量是什么,就相当于问“1”是什么,是没有意义的。

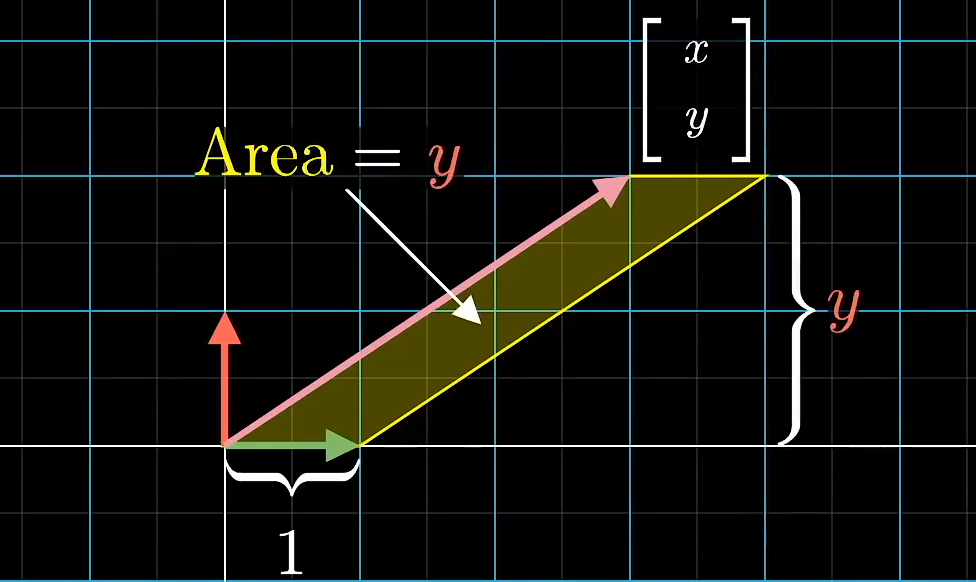

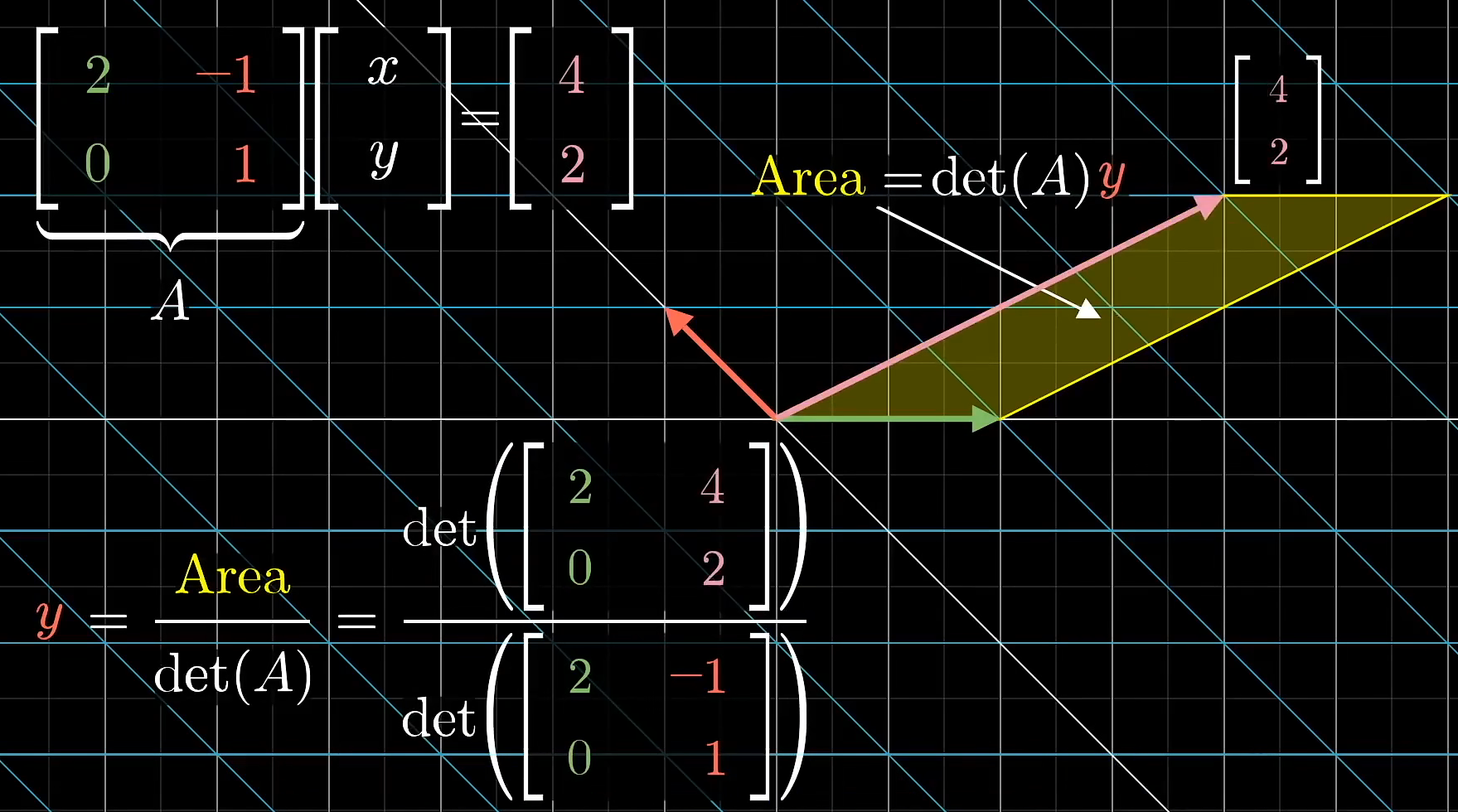

Cramer Rule

求解行列式,计算机使用克莱姆法则,人用高斯消元法;但克莱姆法则有意思的多。

一种独特的表示坐标的方法: y = area/1 , x = area / 1;

这样变换之后的y就还是以绿色基为底的四边形的面积,这正好契合行列式的几何意义;

这时四边形的面积,绿色的基不变(行列式第一列),高度变为变换后的42.

这就是克莱姆法则的几何意义。